0x00 亮点

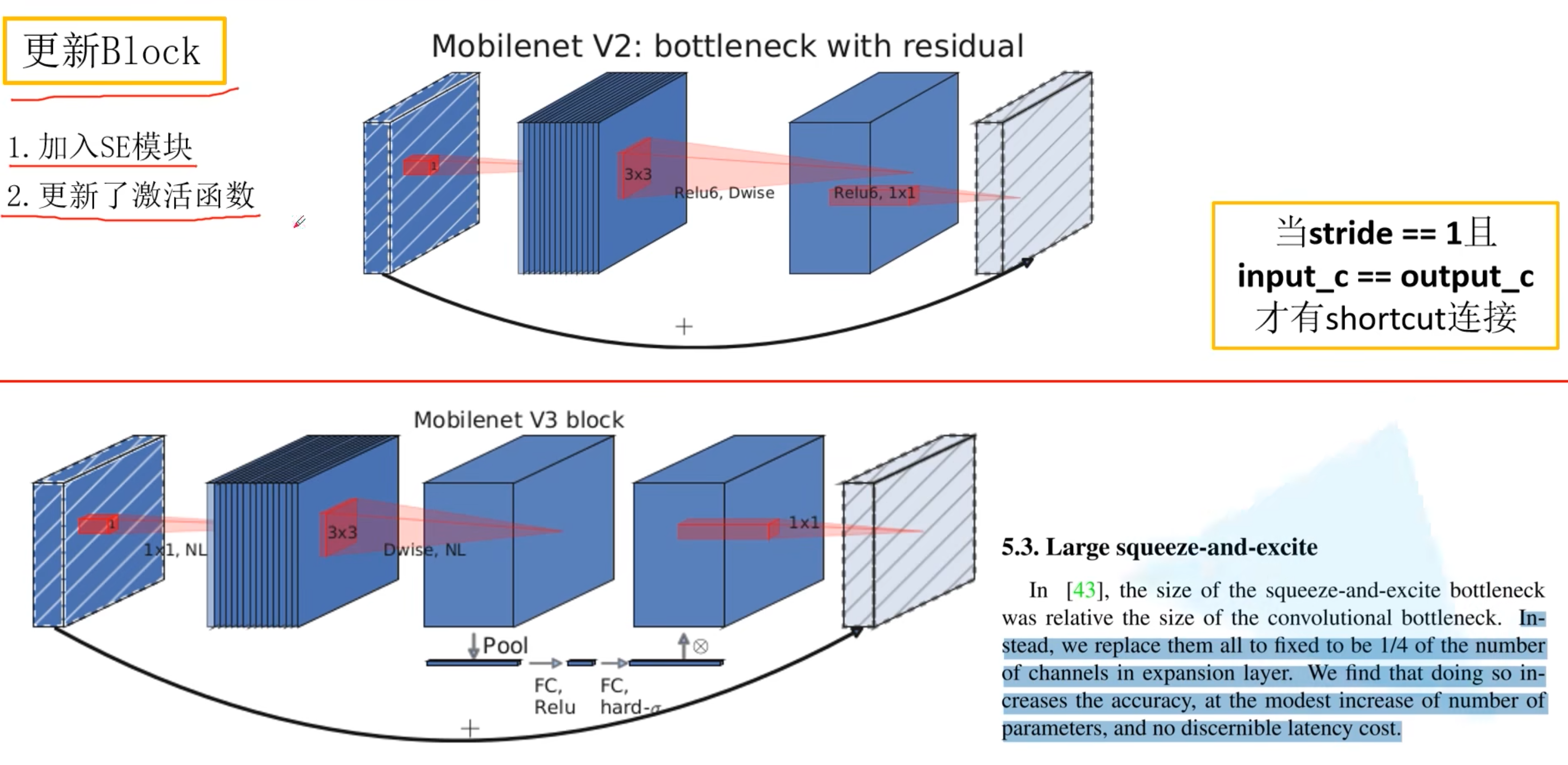

- 更新了Block——bneck

- 使用NAS搜索参数(Neural Architecture Search)

- 重新设计耗时层结构

0x01 更新Block

- 在V2的倒残差结构中加入了SE模块(注意力机制)

- 更新了激活函数——非线性激活函数

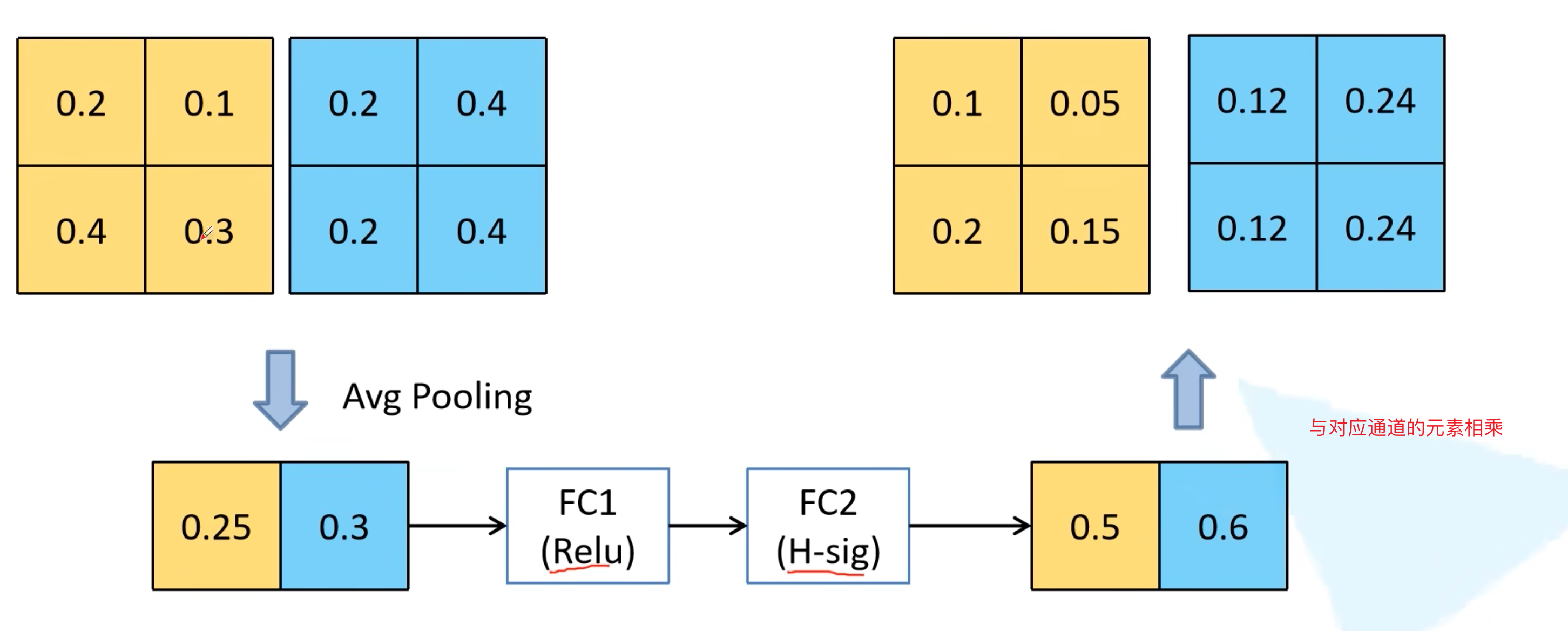

0x02 SE注意力机制

0x03 重新设计激活函数

1. swish函数

也叫SiLU函数

$$swish(x)=x*\sigma(x)$$

计算、求导复杂,对量化过程不友好

2. h-sigmoid函数

$$\sigma(x)=\frac{1}{1+e^{-x}}$$

$$ReLU6(x)=min(max(x,0),6)$$

$$h-sigmoid(x)=\frac{ReLU6(x+3)}{6}$$

3. h-swish函数

$$h-swish(x)=x*h-sigmoid(x)$$

评论 (0)